Un grave incidente di fuga di dati presso GenNomis, una piattaforma gestita dall'azienda sudcoreana di intelligenza artificiale AI-NOMIS, ha sollevato serie preoccupazioni sui rischi derivanti da contenuti generati dall'intelligenza artificiale non monitorati.

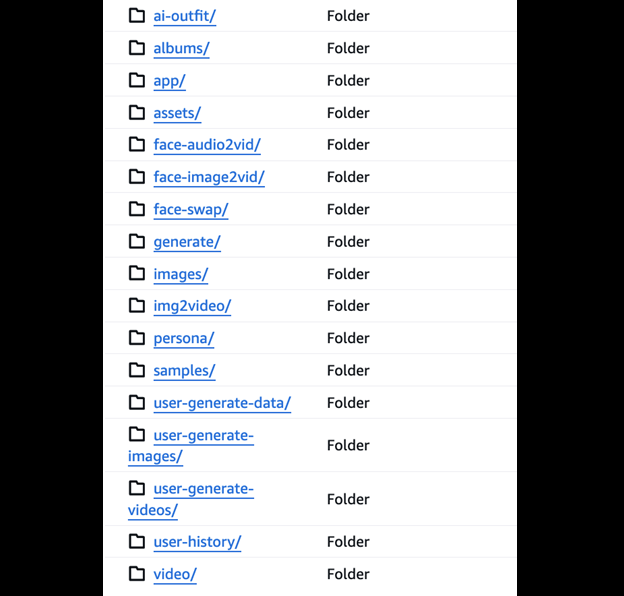

Per vostra informazione, GenNomis è una piattaforma di generazione di immagini basata sull'intelligenza artificiale che consente agli utenti di creare immagini illimitate da prompt di testo, generare personaggi basati sull'intelligenza artificiale ed eseguire lo scambio di volti, con oltre 45 stili artistici e un mercato per l'acquisto e la vendita di immagini generate dagli utenti.

Quali dati sono stati esposti?

Secondo il rapporto di vpnMentor, condiviso con Hackread.com, il ricercatore di sicurezza informatica Jeremiah Fowler ha scoperto un database accessibile al pubblico e configurato in modo errato, contenente ben 47,8 gigabyte di dati, tra cui 93.485 immagini e file JSON.

Questa miniera di informazioni ha rivelato una preoccupante raccolta di materiale esplicito generato dall'intelligenza artificiale, immagini con volti scambiati e raffigurazioni che coinvolgono quelli che sembrano essere individui minorenni. Un esame limitato dei registri esposti ha mostrato una prevalenza di contenuti vietati ai minori, tra cui immagini generate dall'intelligenza artificiale che hanno sollevato segnali di allarme sullo sfruttamento dei minori.

L'incidente rafforza gli avvertimenti di un organismo di controllo di Internet con sede nel Regno Unito, che ha segnalato che i pedofili del dark web utilizzano strumenti di intelligenza artificiale open source per produrre materiale pedopornografico (CSAM).

Fowler ha riferito di aver visto numerose immagini che sembravano raffigurare minorenni in situazioni esplicite, così come celebrità ritratte come bambini, tra cui personaggi come Ariana Grande e Michelle Obama. Il database conteneva anche file JSON che registravano prompt di comando e link a immagini generate, offrendo uno sguardo al funzionamento interno della piattaforma.

Conseguenze e pericoli

Fowler ha scoperto che il database era privo di misure di sicurezza di base, come la protezione tramite password o la crittografia, ma ha dichiarato esplicitamente di non attribuire alcun illecito a GenNomis o AI-NOMIS per l'incidente.

Ha prontamente inviato un avviso di divulgazione responsabile all'azienda e il database è stato eliminato dopo che i siti web GenNomis e AI-NOMIS sono andati offline. Tuttavia, una cartella nel database etichettata "Face Swap" è scomparsa prima che inviasse l'avviso di divulgazione.

Questo incidente evidenzia il crescente problema della pornografia "nudify" o Deepfake, in cui l'intelligenza artificiale viene utilizzata per creare immagini esplicite realistiche senza consenso. Fowler ha osservato, elaborando che circa il 96% dei Deepfake online sono pornografici, con il 99% di questi che coinvolgono donne che non hanno dato il consenso.

Il potenziale di uso improprio dei dati esposti in scenari di estorsione, danno alla reputazione e vendetta è sostanziale. Inoltre, questa esposizione contraddice le linee guida dichiarate dalla piattaforma, che proibiscono esplicitamente contenuti espliciti che coinvolgono bambini.

Fowler ha descritto l'esposizione dei dati come una "chiamata di sveglia" in merito al potenziale di abuso nel settore della generazione di immagini AI, evidenziando la necessità di una maggiore responsabilità da parte degli sviluppatori. Sostiene l'implementazione di sistemi di rilevamento per segnalare e bloccare la creazione di Deepfake espliciti, in particolare quelli che coinvolgono minori, e sottolinea l'importanza delle tecnologie di verifica dell'identità e di filigrana per prevenire l'uso improprio e facilitare la responsabilità.

Al momento in cui scrivo, il sito web GenNomis era offline.

Nessun commento:

Posta un commento